A poco più di un anno dalla celebre sentenza n. 7891/2021, con la quale il Consiglio di Stato ha tentato di circoscrivere i confini della nozione di algoritmo, il nuovo Codice dei contratti, che nel momento in cui si scrive dovrebbe entrare in vigore ad inizio aprile 2023, presenta una novità assoluta: l’introduzione di una norma espressamente dedicata all’Intelligenza Artificiale nel mondo degli appalti. Così, è ancora una volta nelle pieghe del diritto dei contratti pubblici che s’insinuano le ultime novità in materia di nuove tecnologie.

Come si mostrerà nel seguito, ad ogni modo, si tratta per lo più di un’opera di codificazione di principi già esistenti piuttosto che di una legislazione realmente innovativa.

Ma procediamo con ordine.

Innanzitutto, il Codice si apre con un Libro I che già nel titolo contiene un riferimento alla digitalizzazione (“Dei principi, della digitalizzazione, della programmazione e della progettazione”). Di particolare interesse è la Parte II, dedicata alla “digitalizzazione del ciclo di vita dei contratti”, che, citando la relazione dedicata al testo dal Consiglio di Stato, “rappresenta la vera grande sfida dei prossimi anni per realizzare, in chiave moderna, la riforma del sistema economico-sociale e per essere, quindi, pronti a creare e a utilizzare la nuova fonte di ricchezza e di conoscenza rappresentata dai “dati””. Inoltre, ça va sans dire, il tema della digitalizzazione della pubblica amministrazione è strettamente legato alla piena soddisfazione degli obiettivi del PNRR.

Muovendoci sul tema dell’IA, più nello specifico, l’art. 19, co. 7 rinvia all’art. 30: “[o]ve possibile e in relazione al tipo di procedura di affidamento, le stazioni appaltanti e gli enti concedenti ricorrono a procedure automatizzate nella valutazione delle offerte ai sensi dell’articolo 30”. L’art. 30 diviene quindi quadro regolativo per le procedure automatizzate, che a regime dovranno, ove possibile, essere sempre preferite. Sarà tale articolo, che si compone di cinque commi, l’oggetto di questa breve analisi.

Innanzitutto, il comma 1 afferma che “[p]er migliorare l’efficienza le stazioni appaltanti e gli enti concedenti provvedono, ove possibile, ad automatizzare le proprie attività ricorrendo a soluzioni tecnologiche, ivi incluse l’intelligenza artificiale e le tecnologie di registri distribuiti”. Entra così l’espressione “Intelligenza Artificiale” nell’ambito del diritto dei contratti pubblici, assieme a quella di tecnologie di registri distribuiti, traduzione di distributed ledger technologies, genus che comprende le tecnologie di blockchain (1).

Dopo quest’affermazione, piuttosto generica, i tre commi seguenti contengono fondamentali indicazioni normative, sostanzialmente (secondo la Relazione al Codice dei contratti) “principi affermati sia in ambito europeo che dalla giurisprudenza amministrativa”. Il riferimento è, rispettivamente, alla regolamentazione in materia di protezione dei dati personali (Reg. (UE) 2016/679, c.d. “GDPR”) e al copioso filone giurisprudenziale in materia di amministrazione algoritmica che ha avuto origine con la riforma c.d. “Buona Scuola” e in particolare con la celebre sentenza n. 3769/2017 del TAR Lazio — Roma. Senza poter qui ripercorrere il percorso teorico che ha portato all’elaborazione di tali principi, si tenterà di riassumerne brevemente il contenuto — con un’attenzione specifica alla pratica applicativa.

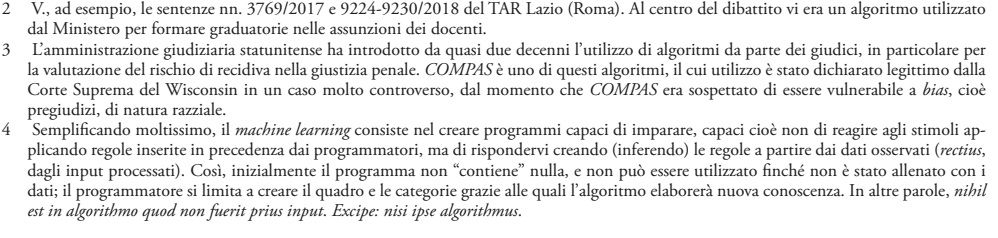

Innanzitutto, la lett. a) del comma 2 afferma l’obbligo di rendere disponibile il codice sorgente (e non solo) degli algoritmi alla base delle procedure automatizzate: le stazioni appaltanti dovranno “assicura[re] la disponibilità del codice sorgente, della relativa documentazione, nonché di ogni altro elemento utile a comprenderne le logiche di funzionamento”. Il tema, che evoca i celebri casi Buona Scuola (a livello nazionale)(2) e COMPAS (negli Stati Uniti)(3), è quello della necessità di trasparenza con riguardo agli algoritmi che vengono utilizzati dalle stazioni appaltanti: nonostante l’eventuale esistenza di diritti di proprietà intellettuale, nel momento in cui un software viene utilizzato nell’ambito di una procedura di gara non è ammessa segretezza in ordine al suo funzionamento.

Restando all’analisi del medesimo comma 2, la lettera b) richiama l’esigenza di evitare che il malfunzionamento delle procedure automatizzate si ripercuota sugli operatori: i rischi derivanti da una maggiore spersonalizzazione dovranno essere bilanciati dalla predisposizione di meccanismi per intervenire in caso di errori informatici. Più precisamente, la pubblica amministrazione dovrà “introdu[rre] negli atti di indizione delle gare clausole volte ad assicurare le prestazioni di assistenza e manutenzione necessarie alla correzione degli errori e degli effetti indesiderati derivanti dall’automazione”.

Il comma più interessante è indubbiamente il terzo, che codifica quattro principi che per alcuni Autori assurgono al vero rango di principi costituzionali del diritto delle nuove tecnologie. Nell’ordine, si tratta dei principi di conoscibilità, comprensibilità, non esclusività e non discriminazione.

Innanzitutto, la coppia conoscibilità-comprensibilità è definita nella lett. a), a mente della quale “ogni operatore economico ha diritto a conoscere l’esistenza di processi decisionali automatizzati che lo riguardino e, in tal caso, a ricevere informazioni significative sulla logica utilizzata”.

Il principio di conoscibilità impone ai pubblici poteri che facciano uso di procedure automatizzate di informare a tale riguardo gli operatori economici; per esempio, mediante l’inserzione di una o più clausole all’interno della lex specialis di gara, e anche negli eventuali provvedimenti individuali che siano esito di procedure automatizzate. Si tratta, sostanzialmente, di un obbligo informativo non difficile da adempiere.

Complementare, e fondamentale in un’ottica di effettività della tutela, è il principio di comprensibilità: la mera conoscenza dell’utilizzo di procedure automatizzate non è sufficiente, senza l’effettiva possibilità di comprendere la “logica utilizzata” (la formulazione riprende letteralmente un’espressione presente negli artt. 13, 14 e 15 del GDPR).

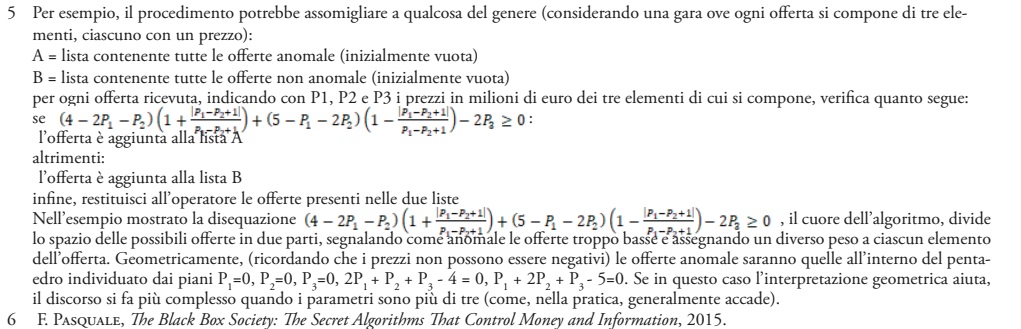

Il principio, assolutamente centrale, soffre di significativi limiti nel momento in cui le procedure automatizzate in questione si basino su tecniche di machine learning (4) (per esempio, su una rete neurale) e non su algoritmi “tradizionali”. Questi ultimi sono interamente forgiati dagli sviluppatori, i quali materialmente scrivono le “istruzioni” che il computer dovrà seguire. In questi casi, la lettura del codice sorgente permette generalmente una comprensione del funzionamento, in senso forte: interpretando correttamente il codice è possibile comprendere i criteri che hanno guidato lo sviluppatore e prevedere il comportamento dell’algoritmo nelle varie situazioni. Così, è agevole verificare se l’algoritmo produce risultati non conformi alla legge, poiché ogni istruzione scritta in linguaggio di programmazione corrisponde ad un’istruzione presente nella mente di chi l’ha creato. Ad esempio, un (semplicissimo e, come si vedrà, errato) algoritmo per l’individuazione delle offerte anomale in una procedura di gara potrebbe essere il seguente:

A = lista contenente tutte le offerte anomale (inizialmente vuota)

B = lista contenente tutte le offerte non anomale (inizialmente vuota) per ogni offerta ricevuta, verifica quanto segue:

• se ribasso > soglia di anomalia:

l’offerta è aggiunta alla lista B

• altrimenti:

l’offerta è aggiunta alla lista A

infine, restituisci all’operatore le offerte presenti nelle due liste.

L’algoritmo produce risultati non conformi alla legge, poiché porta a ritenere anomale le offerte che non dovrebbero esserlo, e viceversa: l’errore è facilmente riconoscibile e può essere corretto invertendo il segno > con un segno <.

Una chiarezza tale non è generalmente ravvisabile in caso di machine learning, poiché in questo caso lo sviluppatore stesso può non riuscire a prevedere con sicurezza il comportamento dell’algoritmo. Il problema, in questo caso, è che non vi è collegamento diretto tra regola applicata nel caso specifico e pensiero dello sviluppatore: quest’ultimo dona all’algoritmo delle “categorie concettuali”, ma è l’algoritmo che “allenandosi” individua delle relazioni tra i dati forniti in modo da estrapolarne delle regole.

Per restare al tema delle offerte anomale, si immagini una legge che imponga alle stazioni appaltanti di individuare la soglia di anomalia non limitandosi alle offerte in gara, come accade ora, ma avvalendosi di un database contenente tutte le offerte per gare bandite sull’intero territorio nazionale, o persino europeo, al fine di valutare il grado di scostamento della singola offerta rispetto all’offerta “ordinaria”, per singoli elementi omogenei. Lo sviluppatore dovrà scegliere una tecnica di machine learning (per esempio, apprendimento non supervisionato) e fornire come dati di allenamento (“training dataset”) il database contenente tutte le offerte, così che l’algoritmo possa imparare a riconoscere quale è la normalità (“assenza di anomalie nell’offerta”). Sarà poi l’algoritmo così allenato a segnalare, all’interno della singola gara, le offerte anomale. Qualora un concorrente escluso volesse conoscere le ragioni dell’esclusione, potrebbe scoprire che il procedimento utilizzato è di fatto imperscrutabile (5).

Tutto infatti potrebbe dipendere da determinati criteri elaborati dall’algoritmo, non da un umano, che possono essere di una complessità tale da rendere sostanzialmente impossibile comprendere il perché della specifica decisione: utilizzando un’espressione coniata da Frank Pasquale (6), spesso gli algoritmi di machine learning sono come black boxes, imperscrutabili dall’esterno. È evidente, pertanto, l’enorme differenza che connota gli algoritmi di ultima generazione.

In questi casi, probabilmente, il diritto “a ricevere informazioni significative sulla logica utilizzata” si sostanzierebbe nel diritto a conoscere la tecnica utilizzata e i dati alla base dell’allenamento, ma con un’effettività della tutela decisamente minore: fermo restando che già nella scelta della tecnica o dei dati possono essere individuati contrasti con norme di legge, riconoscibili più o meno agevolmente, il sindacato dovrà probabilmente arrestarsi su questa soglia, posta l’incomprensibilità della regola del caso particolare.

Il secondo principio enunciato dall’art. 3 è il principio di non esclusività, a mente del quale deve sempre “esiste[re] nel processo decisionale un contributo umano capace di controllare, validare ovvero smentire la decisione automatizzata”. A tal proposito, si parla anche di c.d. human-in-theloop (HITL), “(decisore) umano all’interno del processo”, di cui si individuano tradizionalmente due varianti: ex ante ed ex post HITL. Mentre nel primo caso un umano deve affiancare il sistema automatico sin dall’inizio, anteriormente al momento in cui la decisione viene presa, nel secondo caso l’intervento umano è solo posteriore alla decisione e, in particolare, può essere solo eventuale attivandosi in caso di istanza da parte del destinatario della decisione. La differenza, come si può intuire, è notevole:

sia da un punto di vista di risorse (il rispetto del principio nella sua forma ex ante è molto più dispendioso), sia (soprattutto) dal punto di vista del peso dei sistemi

automatici: nel caso di controllo ex post solo eventuale, la procedura è fisiologicamente portata avanti in assenza di alcun controllo umano, e ciò comporta un protagonismo assoluto per i sistemi automatici utilizzati.

L’ultimo principio citato nel comma 3 è il principio di non discriminazione algoritmica, a mente del quale “il titolare mette in atto misure tecniche e organizzative adeguate al fine di impedire effetti discriminatori nei confronti degli operatori economici”. Tale principio costituisce una traduzione nel mondo dell’amministrazione algoritmica del principio di imparzialità della pubblica amministrazione, e la sua portata precettiva è puntualizzata anche al successivo quarto comma: “Le stazioni appaltanti e gli enti concedenti adottano ogni misura tecnica e organizzativa atta a garantire che siano rettificati i fattori che comportano inesattezze dei dati e sia minimizzato il rischio di errori, nonché a impedire effetti discriminatori nei confronti di persone fisiche sulla base della nazionalità, dell’origine etnica, delle opinioni politiche, della religione, delle convinzioni personali, dell’appartenenza sindacale, dei caratteri somatici, dello status genetico, dello stato di salute, del genere o

dell’orientamento sessuale”.

Anche in questo caso occorre distinguere tra algoritmi “tradizionali” e algoritmi di machine learning. Nel primo caso, infatti, il rispetto del principio non esige probabilmente un quid pluris rispetto a quanto già avviene con i normali atti amministrativi, poiché l’algoritmo costituisce comunque diretta emanazione della volontà dello sviluppatore. L’eventuale carattere discriminatorio di un algoritmo tradizionale dovrebbe quindi essere facilmente individuabile e sindacabile con i parametri oggi utilizzati per gli atti amministrativi. Il discorso muta completamete, anche qui, quando la pubblica amministrazione decida di avvalersi di machine learning. In questi casi, come ormai noto, la scelta dei dati assume un peso preponderante nelle prestazioni dell’algoritmo. Nella letteratura scientifica si parla, a tal proposito, di Garbage In-Garbage Out (GIGO, letteralmente “spazzatura dentro, spazzatura fuori”): la qualità degli output dipende dalla qualità dei dati di training, e utilizzare dati di scarsa qualità comporta creare algoritmi di scarsa qualità. In altre parole, un algoritmo di machine learning è ciò che mangia. Di conseguenza, la pubblica amministrazione dovrà avere particolare attenzione per i dati alla base dei sistemi utilizzati, per evitare criticità emerse, per esempio, con il celebre caso COMPAS, già oggetto di riflessione nelle pagine di questa rivista.

In conclusione, l’intervento normativo qui tratteggiato si presenta come fondamentale dal punto di vista della chiarezza, poiché consente di dare una qualche stabilità a principi che finora non avevano trovato spazio nel diritto amministrativo positivo. Ciò che è certo, però, è che tale codificazione non dovrà risultare in una precoce cristallizzazione, considerando che, come evidenziato dal Consiglio di Stato nella Relazione, tale opera è “volta a disciplinare il futuro (prossimo), in quanto, allo stato, nell’ambito delle procedure di gara sono utilizzati per lo più algoritmi non di apprendimento, utilizzati per il confronto automatico di alcuni parametri caratterizzanti le offerte e conoscibili”. Si tratta dunque di un intervento che consolida alcuni risultati giurisprudenziali e prepara il campo per ulteriori futuri sviluppi. Il nuovo Codice, così come la proposta di Regolamento sull’IA a livello Europeo, dimostra che il fenomeno dell’Intelligenza Artificiale è e sarà sempre più un tema che il legislatore non potrà evitare di considerare e con il quale gli operatori del settore dei pubblici appalti dovranno confrontarsi.

La strada appare tracciata.

di Federico Fidanza – Studio legale Fidanza

Articolo tratto da TEME 1-2/2023